Rotacja klientów jest jednym z kluczowych wyzwań, przed którymi stoją organizacje w czasach obecnie panującej wysokiej konkurencji. Aby skutecznie walczyć z odchodzeniem klientów, firmy powinny znaleźć odpowiedzi na dwa kluczowe zagadnienia: którzy klienci zagrożeni są rezygnacją oraz podjęcie jakich działań może zahamować ten proces.

Z pomocą przychodzi połączenie dwóch metod z arsenału data science: predykcji i klastrowania (segmentacji), które razem zwiększają skuteczność działań retencyjnych.

Kwestię predykcji zagrożenia odchodzeniem klientów, poruszałem już w jednym z artykułów w ramach cyklu We Love Data So Let’s Date. Ze względu na wagę tematu oraz na zainteresowanie, jakie wywołał postanowiłem pogłębić zagadnienie i przedstawić podejście, w którym dzięki połączeniu dwóch metod uczenia maszynowego możemy znacząco ułatwić wdrożenie w życie działań antychurnowych opartych o dane.

Predykcja i segmentacja jako broń w walce z odchodzeniem klientów

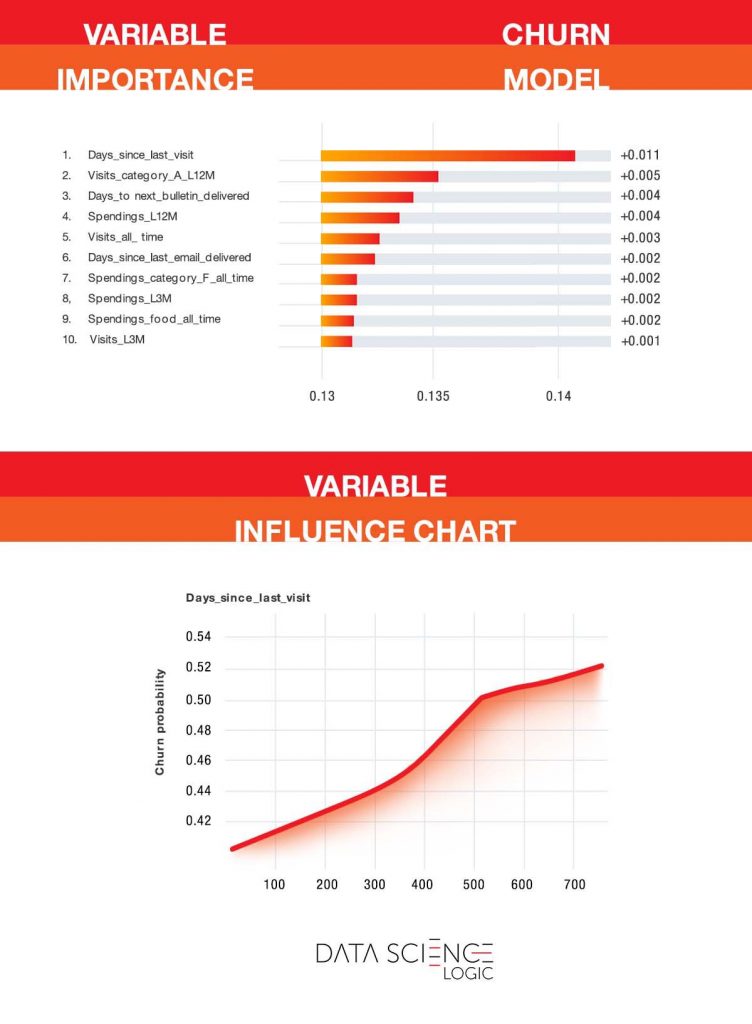

Podstawowym narzędziem w przeciwdziałaniu rezygnacji klientów jest model predykcyjny. Pozwala on na przewidywanie prawdopodobieństwa odejścia konkretnego konsumenta. To jednak może nie wystarczyć. Nawet najlepszy model i najdokładniejsza predykcja nie przydadzą się, jeśli na podstawie otrzymanych informacji nie podejmiemy odpowiednich działań.

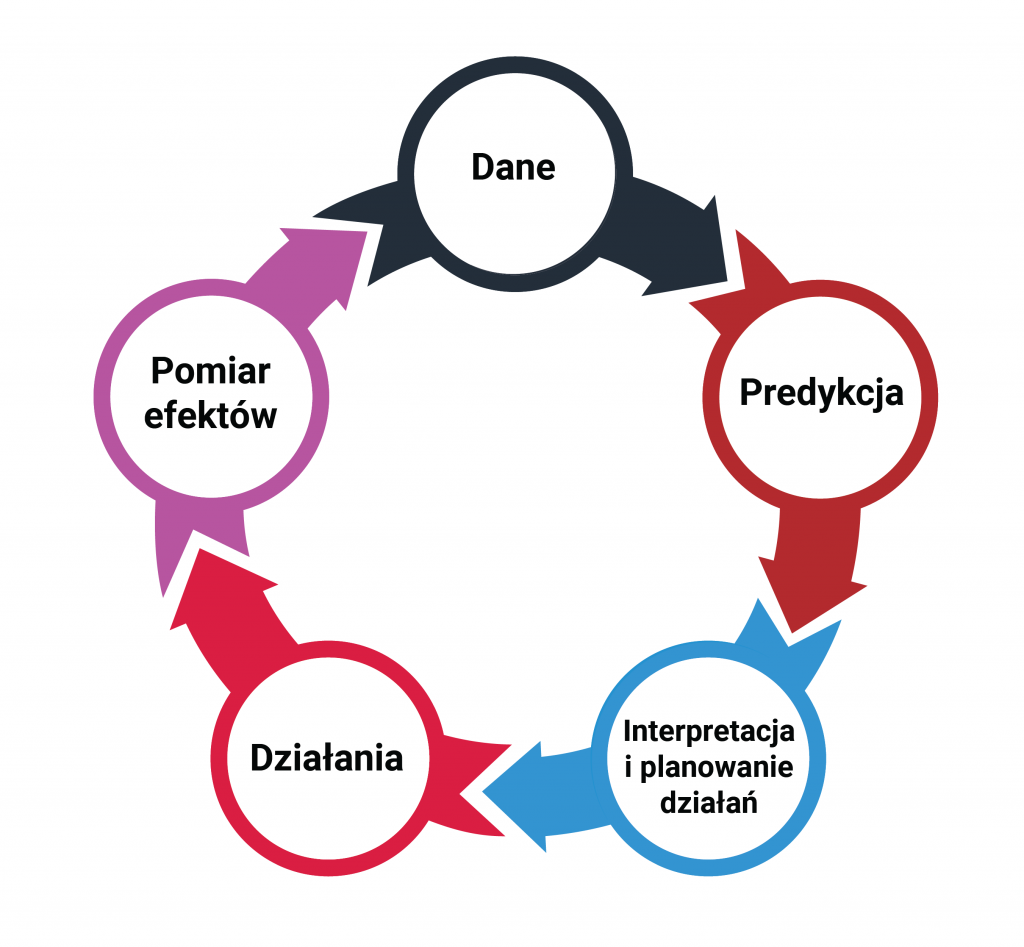

Odpowiednia interpretacja danych pozwala na planowanie działań i podejmowanie akcji – np. wysyłki komunikatu sms do klientów lub zaoferowanie rabatu na wybrane produkty. Następnie mierzymy wpływ działań (efekt) na zachowania konsumentów i ich skłonność do rezygnacji z dalszego korzystania z oferty. Pomiar i obserwacja zachowań konsumentów stanowi źródło nowych danych, z których korzystać może model predykcyjny. W ten sposób cykl się zamyka, a obrazuje to poniższy schemat.

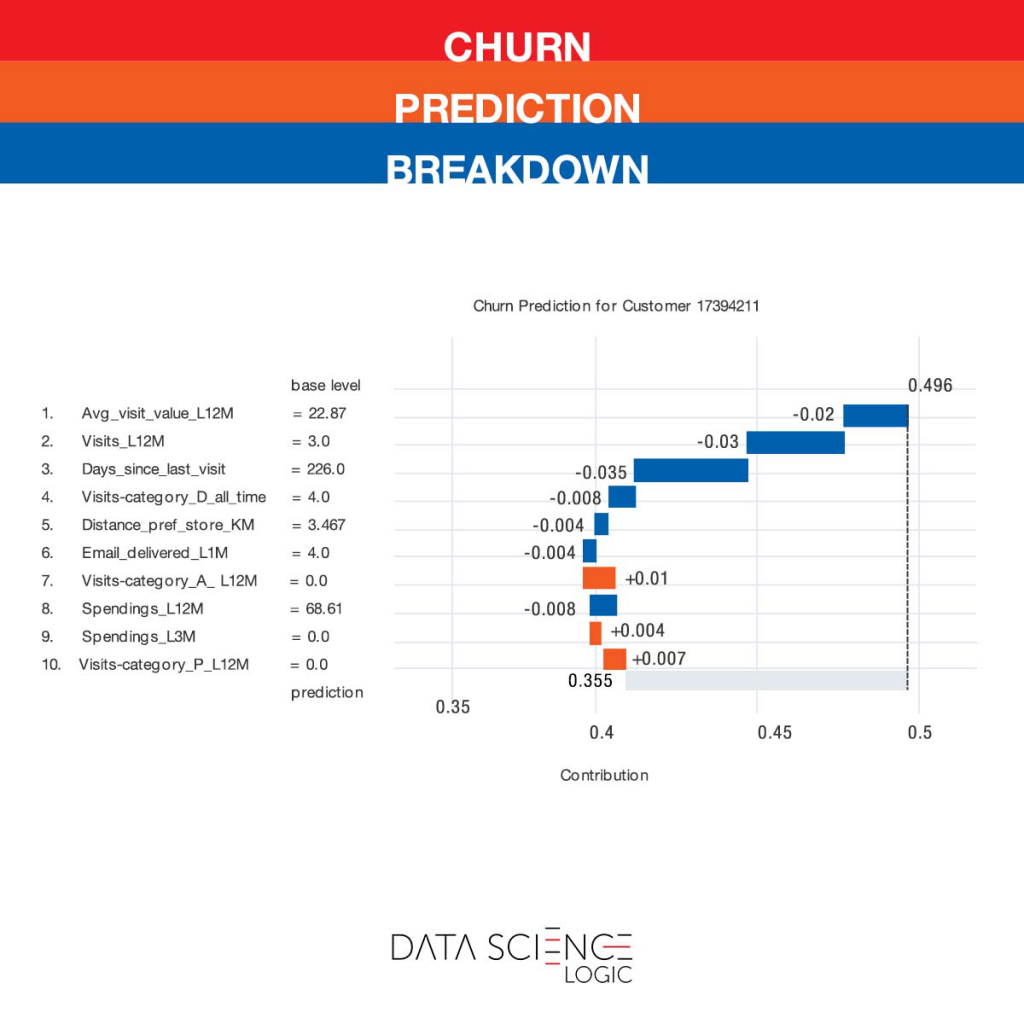

Model predykcyjny wskazuje prawdopodobieństwo rezygnacji konkretnego klienta. Pozwala to na priorytetyzację zadań i wykorzystanie ograniczonych zazwyczaj zasobów na konsumentach najbardziej zagrożonych odejściem. Informacja, że konsument z 75% prawdopodobieństwem odejdzie od nas w ciągu najbliższego kwartału pomaga nam podjąć decyzję, że „coś” z tym musimy szybko zrobić. Czy daje jednak wiedzę co należy zrobić? Skąd firma ma wiedzieć jakie działania podjąć? Kluczem jest właściwa interpretacja danych.

Sytuacją idealną byłaby możliwość podjęcia działań spersonalizowanych pod kątem pojedynczego konsumenta. Czyli każdy klient otrzymałby unikatową dostosowaną do jego potrzeb i problemów ofertę. Modele predykcyjne zbudowane w oparciu o odpowiednio dobrane metody uczenia maszynowego pozwalają na stworzenie indywidualnego profilu każdego konsumenta. Dodatkowo wskazują konkretne czynniki, które w jego przypadku skojarzone są z wyższym ryzykiem odejścia. Pomimo postępów w obszarze hiperpersonalizacji działań marketingowych, dla wielu organizacji wciąż nie jest jeszcze ona osiągalna na dużą skalę. Nie wszystkie działania mogą być równie łatwo automatyzowane. Ograniczeniem może być np. kreacja, produkcja contentu czy budowa oferty.

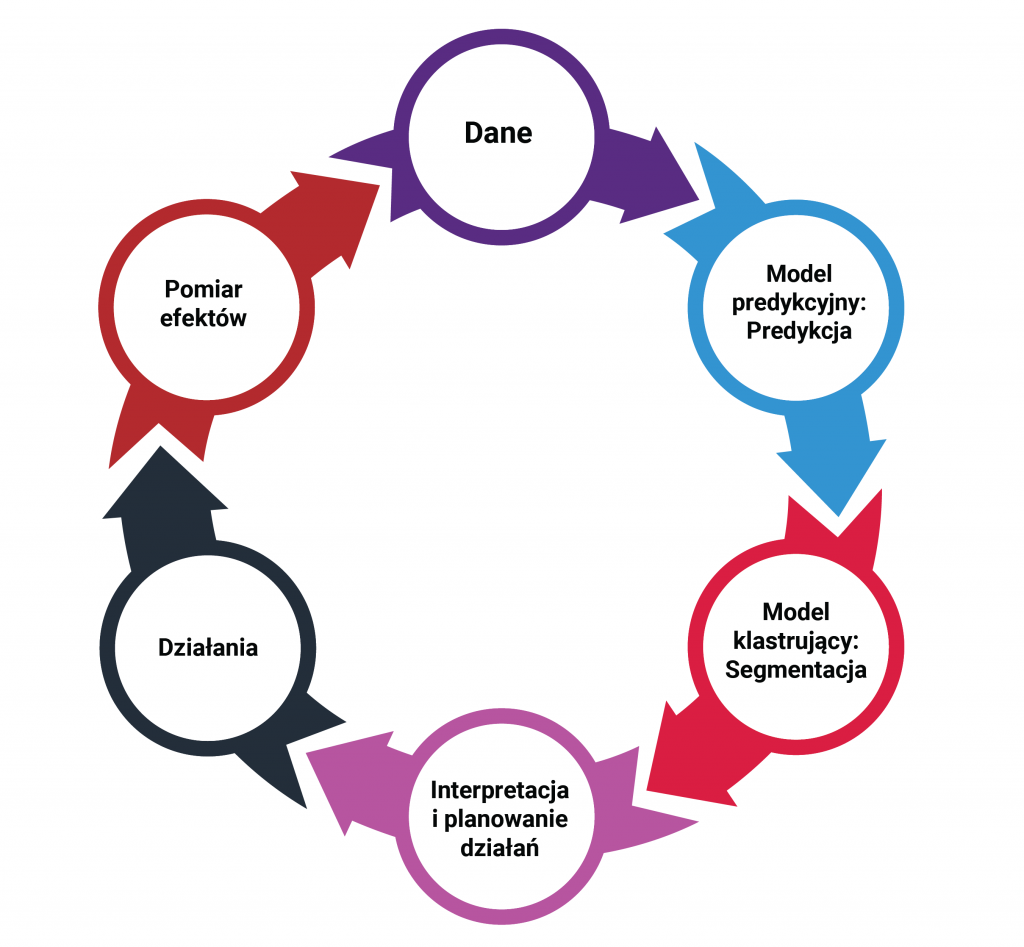

Rozwiązaniem w takim przypadku jest podejście oparte o zaawansowaną segmentację. Zdecydowanie nie chodzi tu jednak o klasyczne segmenty, które wykorzystują tylko podstawowe zmienne typu wiek czy płeć. Nie różnicują one wystarczająco bazy, a prawdziwe linie podziału przebiegają zupełnie gdzie indziej. Istotne jest więc żeby była to segmentacja behawioralna, w której szukamy podobieństw w zachowaniach klientów, biorąc pod uwagę ten sam szeroki agregat opisujących zmiennych, jaki był wykorzystany do budowy modelu predykcyjnego. Do przeprowadzenia tak kompleksowej segmentacji konieczne są klastrujące algorytmy uczenia maszynowego.

Procedura może wyglądać następująco:

- Model predykcyjny pozwala na wyłonienie grupy najbardziej zagrożonych klientów.

- Decydujemy, że mamy zasoby na działania wobec 20% najbardziej zagrożonych klientów.

- Wybieramy tych klientów i przy pomocy modelu klastrującego dzielimy ich na segmenty. Ich liczba powinna być wypadkową wskazań modelu oraz zasobów jakimi dysponujemy do ich obsługi (zazwyczaj będzie to ich kilka – kilkanaście).

- Interpretujemy segmenty i planujemy działania.

Zaproponowana metoda pozwala wykorzystać w praktyce modelowanie predykcyjne i dostarczane przez analizy data science pogłębione zrozumienie konsumentów zagrożonych odejściem. Podejście znajdzie zastosowanie także w firmach niegotowych jeszcze technologicznie i organizacyjnie na w pełni zautomatyzowane działania hiperpersonalizacyjne.